Djangoでrobots.txtを設定する 問題解決技術

Djangoでrobots.txtを設定する 問題解決技術

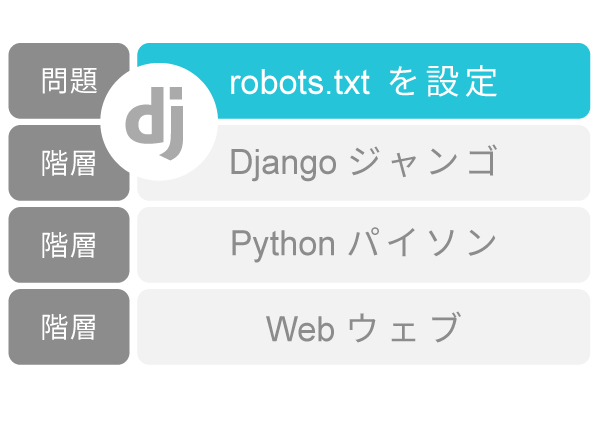

技術:Djangoでrobots.txtを設定する

問題:Djangoでrobots.txtを設定して、グーグルクローラーにクロールしないように指示を出したい。グーグルクローラーがサイトページをすべてクロールしてしまっていた。不必要なページが、グーグルのアドポリシー違反となり、警告が繰り返された。

URLディレクトリの設定:

from django.urls import include, path

from django.views.generic import TemplateView

path('robots.txt', TemplateView.as_view(template_name='static/robots.txt', content_type='text/plain')),

TemplateViewを利用して、robots.txtへのパスを設定しますtemplate/static/ディレクトリの設定:

template/static/ディレクトリにrobots.txtを作成します。robots.txtの記入例:

Disallow: /abcfile

Disallow: /abcfileと記入すると、abcfileにグーグルがクロールしないように指示を出せます。探究資料:

質問と回答